目录

一、全局唯一Id简介

系统当中有些场景如果使用数据库自增ID就存在一些问题:

- id的规律性太明显

- 受单表数据量的限制

场景分析:如果我们的id具有太明显的规则,用户或者说商业对手很容易猜测出来我们的一些敏感信息,比如商城在一天时间内,卖出了多少单,这明显不合适。

场景分析二:随着我们商城规模越来越大,mysql的单表的容量不宜超过500W,数据量过大之后,我们要进行拆库拆表,但拆分表了之后,他们从逻辑上讲他们是同一张表,所以他们的id是不能一样的, 于是乎我们需要保证id的唯一性。

全局唯一ID生成策略:

- UUID

- Redis自增

- snowflake算法

- 数据库自增

Redis自增ID策略:

- 每天一个key,方便统计订单量

- ID构造是 时间戳 + 计数器

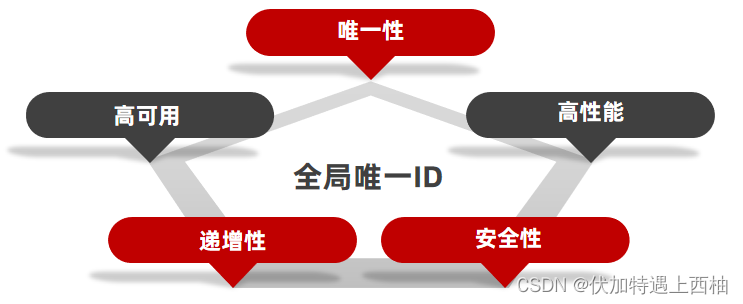

全局ID生成器,是一种在分布式系统下用来生成全局唯一ID的工具,一般要满足下列特性:

为了增加ID的安全性,我们可以不直接使用Redis自增的数值,而是拼接一些其它信息:

D的组成部分:符号位:1bit,永远为0

时间戳:31bit,以秒为单位,可以使用69年

序列号:32bit,秒内的计数器,支持每秒产生2^32个不同ID

二、Redis实现全局唯一Id实践

2.1添加RedisIdWorker配置类

package com.example.idgenerate.config;

import org.springframework.data.redis.core.StringRedisTemplate;

import org.springframework.stereotype.Component;

import java.time.LocalDateTime;

import java.time.ZoneOffset;

import java.time.format.DateTimeFormatter;

@Component

public class RedisIdWorker {

/**

* 开始时间戳,此处的时间戳为预生成

*/

private static final long BEGIN_TIMESTAMP = 1640995200L;

/**

* 序列号的位数

*/

private static final int COUNT_BITS = 32;

private StringRedisTemplate stringRedisTemplate;

public RedisIdWorker(StringRedisTemplate stringRedisTemplate) {

this.stringRedisTemplate = stringRedisTemplate;

}

/**

* 描述信息: 生成唯一id

*

* @date 2023/05/21

* @param keyPrefix 前缀,用于区分不同的业务

* @return long id

**/

public long nextId(String keyPrefix) {

// 1.生成时间戳

LocalDateTime now = LocalDateTime.now();

long nowSecond = now.toEpochSecond(ZoneOffset.UTC);

long timestamp = nowSecond - BEGIN_TIMESTAMP;

// 2.生成序列号

// 2.1.获取当前日期,精确到天

String date = now.format(DateTimeFormatter.ofPattern("yyyy:MM:dd"));

// 2.2.自增长 key格式:icr:order:2023:05:21

long count = stringRedisTemplate.opsForValue().increment("icr:" + keyPrefix + ":" + date);

// 3.拼接并返回,目的是让时间戳存放在32上,序列号在低32位

return timestamp << COUNT_BITS | count;

}

}

2.2测试类

@Autowired

private RedisIdWorker redisIdWorker;

/**

* 描述信息:将日期时间转成秒级数字

*

* @date 2023/05/21

* @return void

**/

@Test

void contextLoads() {

LocalDateTime time = LocalDateTime.of(2023, 5, 20, 0, 0,0);

//将时间转成秒数

long second = time.toEpochSecond(ZoneOffset.UTC);

System.out.println("second = " + second);

}

//实际项目中应使用自定义的线程池

private ExecutorService es = Executors.newFixedThreadPool(500);

/**

* 描述信息: 测试redis生成3w条id所需要的时间

*

* @date 2023/05/21

* @return void

**/

@Test

void testIdWorker() throws InterruptedException {

CountDownLatch latch = new CountDownLatch(300);

Runnable task = () -> {

for (int i = 0; i < 100; i++) {

long id = redisIdWorker.nextId("order");

System.out.println("id = " + id);

}

latch.countDown();

};

long begin = System.currentTimeMillis();

for (int i = 0; i < 300; i++) {

es.submit(task);

}

latch.await();

long end = System.currentTimeMillis();

System.out.println("time = " + (end - begin));

}

知识小贴士:关于countdownlatch

countdownlatch名为信号枪:主要的作用是同步协调在多线程的等待于唤醒问题

我们如果没有CountDownLatch ,那么由于程序是异步的,当异步程序没有执行完时,主线程就已经执行完了,然后我们期望的是分线程全部走完之后,主线程再走,所以我们此时需要使用到CountDownLatch

CountDownLatch 中有两个最重要的方法

1、countDown

2、await

await 方法是阻塞方法,我们担心分线程没有执行完时,main线程就先执行,所以使用await可以让main线程阻塞,那么什么时候main线程不再阻塞呢?当CountDownLatch 内部维护的 变量变为0时,就不再阻塞,直接放行,那么什么时候CountDownLatch 维护的变量变为0 呢,我们只需要调用一次countDown ,内部变量就减少1,我们让分线程和变量绑定, 执行完一个分线程就减少一个变量,当分线程全部走完,CountDownLatch 维护的变量就是0,此时await就不再阻塞,统计出来的时间也就是所有分线程执行完后的时间。

到此这篇关于Redis实现全局唯一Id的使用示例的文章就介绍到这了,更多相关Redis 全局唯一Id内容请搜索脚本之家以前的文章或继续浏览下面的相关文章希望大家以后多多支持脚本之家!

本文由 华域联盟 原创撰写:华域联盟 » Redis实现全局唯一Id的使用示例

转载请保留出处和原文链接:https://www.cnhackhy.com/157516.htm